微软发布LLMLingua,突破上下文长度限制,开创Prompt压缩技术新思路

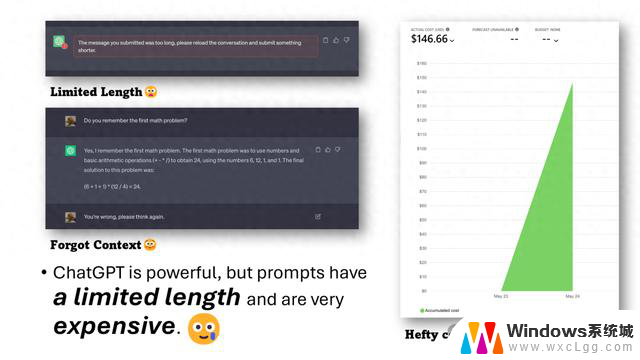

一般的解决思路是通过训练更优秀的大模型来解决,但众所周知,由于大模型的二次复杂度,Context window(上下文长度)提升相对困难。再加之直接使用OpenAI等云服务接口,无法更换模型的开发者来讲,如何扩展上下文长度呢?

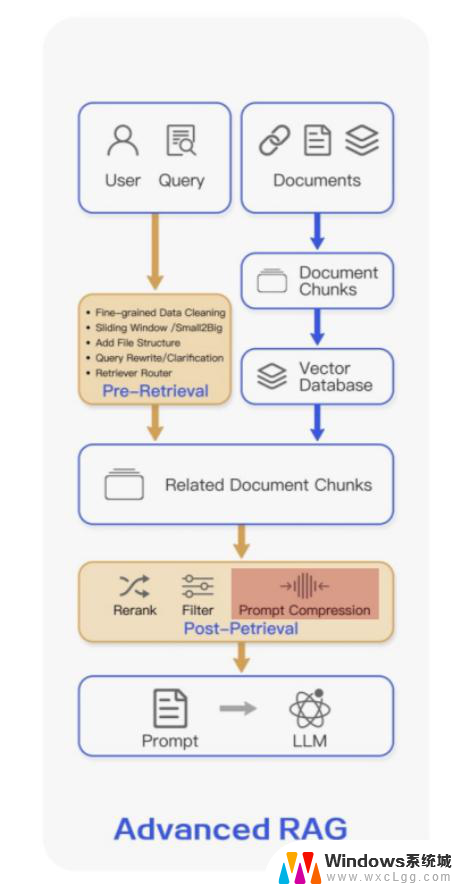

有一个比较直接的思路就是对Prompt进行压缩,它的基本假设就是自然语言本身是存在冗余的。在一些实际的高阶RAG架构中,Prompt压缩也可以作为一个模块内置在系统中。

比如,在langchain中,对于多轮的对话上下文进行压缩总结从而达到减少Prompt的目的。

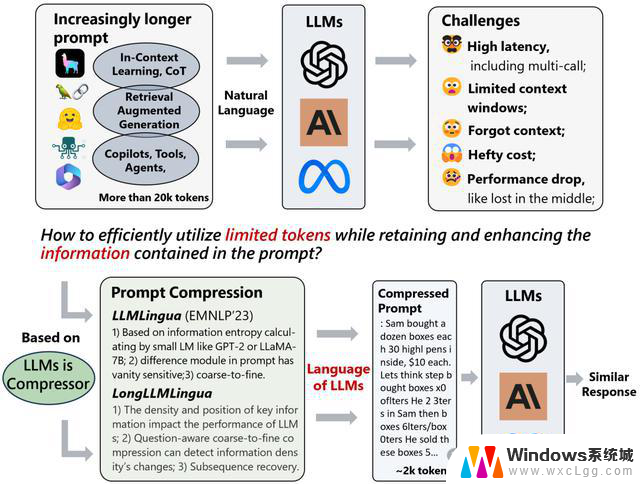

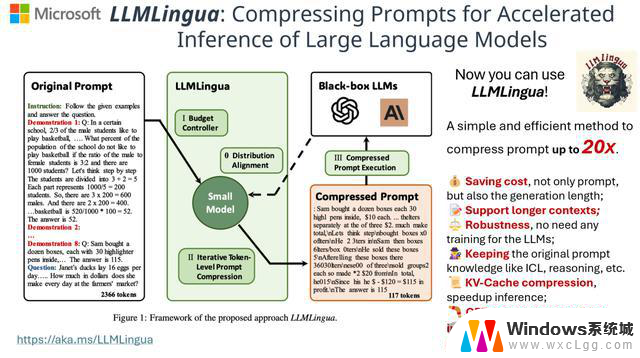

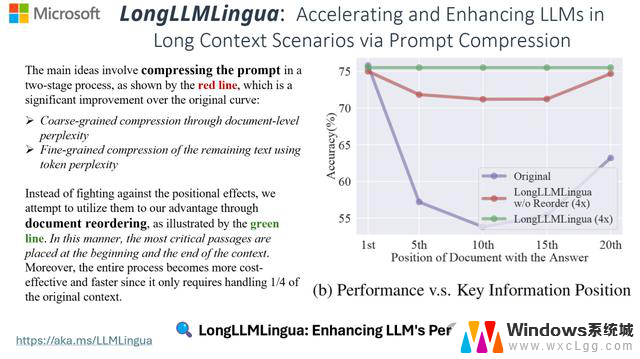

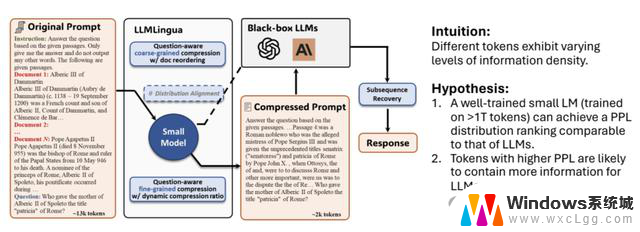

基于这样的思路,微软在十月份公布了一项他们的研究进展。称受论文Ilya的LLMs is Compressors的观点启发,他们开发了一款工具LLMLingua及LongLLMLingua,实现了 20 倍的压缩比和最小的性能损失 (LLMLingua),以及 17.1% 的 4 倍压缩 (LongLLMLingua) 的性能提升,进而达到加速模型推理、降低成本并提高下游性能的目的。

其实现的基本思路是通过训练一个小的模型来对原始的Prompt进行压缩,从而获得更小的Prompt,再提交给大模型生成,并对生成结果进行解压。

在此基础上论文还提出了如下的Insights:

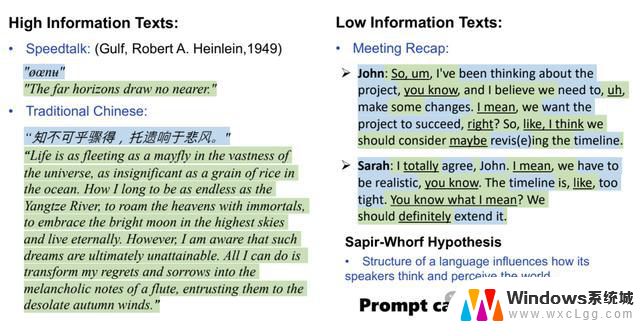

1.自然语言存在冗余性,信息量不尽相同。

2.LLM 可以理解被压缩后的Prompt。

3.LLMLingua是在语言完整性和压缩率之间进行权衡。

4.GPT-4 可以从被压缩的具有涌现能力的Prompt中恢复所有关键信息。(LLMLingua)

5.Prompt中关键信息的密度和位置会影响下游任务的性能。(LongLLMLingua)

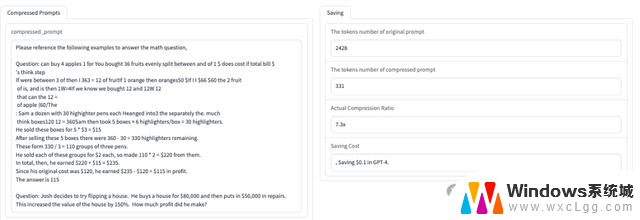

使用方法也比较简单:

除此之外,还提供了该工具的使用例子和压缩效果直观展示。

https://huggingface.co/spaces/microsoft/LLMLingua

微软发布LLMLingua,突破上下文长度限制,开创Prompt压缩技术新思路相关教程

-

微软团队AI辅助游戏剧情创作,叙事设计创新思路

微软团队AI辅助游戏剧情创作,叙事设计创新思路2024-11-07

-

-

我国自主研发的新一代国产CPU发布:开创中国芯片技术新纪元

我国自主研发的新一代国产CPU发布:开创中国芯片技术新纪元2023-11-28

-

-

微软AI云业绩飙升,下季度销售或突破百亿美元

微软AI云业绩飙升,下季度销售或突破百亿美元2024-10-31

-

2023年度技术创新奖:AMD锐龙7040系列移动处理器,领跑技术创新风潮!

2023年度技术创新奖:AMD锐龙7040系列移动处理器,领跑技术创新风潮!2023-12-27

- 全自主研发!新一代国产CPU打破国外技术垄断

- 英伟达:超级GPU的唯一制造者,领先全球的GPU技术创新者

- 微软开发出一种可在CPU上运行的超高效AI模型,革新人工智能技术领域

- 微软Office新突破:Android无需登录即可查看文档,办公更便捷

- 减配不减价?英伟达在华推出“二次阉割”显卡,用户反响几何?

- AMD市占,创历史新高:全球市场份额达到新高,AMD强势崛起

- 英伟达50 SUPER显卡或加量不加价:曝5080 SUPER售999美元,性价比超高!

- 为何网友认为WindowsXP与Windows7是最经典版本?- 为什么这两款操作系统备受推崇?

- 一家初创公司,要颠覆传统CPU,势必引领新一轮科技变革

- 微软Win11 24H2八月累积更新遇0x80240069错误解决方法

微软资讯推荐

- 1 减配不减价?英伟达在华推出“二次阉割”显卡,用户反响几何?

- 2 AMD市占,创历史新高:全球市场份额达到新高,AMD强势崛起

- 3 为何网友认为WindowsXP与Windows7是最经典版本?- 为什么这两款操作系统备受推崇?

- 4 AMD新款旗舰X3D计划曝光,双CCD 3D V-Cache产品是否存在?

- 5 历史首次!AMD服务器CPU市占率达50%:行业格局将如何变化?

- 6 初探微软Win11快速机器恢复功能:自动修复启动故障的操作步骤

- 7 英伟达回应:产品中绝对没有后门、终止开关或监控软件

- 8 基于国产CPU和OS的LLM应用开发平台资源计算方法专利

- 9 100元8代E3神教2144 2174 2274G处理器攻略:功耗50瓦U2固态32万分解析

- 10 Win10文件删除不了?教你两招轻松搞定,轻松解决Win10文件删除困难问题

win10系统推荐

系统教程推荐

- 1 笔记本开机闪屏是什么原因,怎么解决 笔记本电脑频繁闪屏怎么办

- 2 win10怎么更改子网掩码 Win10更改子网掩码步骤

- 3 声卡为啥没有声音 win10声卡驱动正常但无法播放声音怎么办

- 4 固态硬盘装进去电脑没有显示怎么办 电脑新增固态硬盘无法显示怎么办

- 5 word如何加批注 Word如何插入批注

- 6 怎么让word显示两页并排 Word文档同屏显示两页

- 7 win11直接改文件后缀 win11文件后缀修改教程

- 8 win11怎么查看电脑的物理地址 电脑物理地址查询方法

- 9 switch手柄对应键盘键位 手柄按键对应键盘键位图

- 10 win11安装共享打印机提示0000709 win11共享打印机提示0000709问题解决方法