Nvidia探讨用生成式AI强化安全的3种方式:加固网络防御、提升威胁检测和加强数据隐私保护

用生成式AI帮助安全,是2023年相当火热的议题。我们看到微软、Google等多家安全企业,积极打造AI助理帮助安全人员,不过安全问题不仅于此,还有GitHub Copilot新发展的AI漏洞过滤系统,将能用于帮助开发人员,可在开发阶段就及时阻挡不安全程序代码的写法,包括写死凭证、SQL注入与路径注入等。

对于一般企业、非安全公司而言,我们又可以如何设想生成式AI的应用,帮助企业内部的安全强化呢?

最近2023年底,我们看到有企业公开说明相关应用,特别的是,这家公司就是以GPU闻名全球、因AI芯片再度成为市场焦点的Nvidia。该公司首席安全官David Reber Jr.特别发布专文介绍,阐述3种应用生成式AI加强安全的方式。

尽管Nvidia公司并非安全产业,但他们是从自身企业角度去设想,加上本身对于生成式AI的理解,并实际提出企业可发展与关注的方向,也相当值得借鉴。

David Reber Jr.首先强调的是,安全攻击速度与复杂性的逐渐增加,已经让人类分析师无法有效应对,因为数据量过大,无法手动筛选。面对这样的时局,他指出,当今最具变革性的工具──就是生成式AI。

如何用生成式AI加强安全?

第一种方式,从开发人员开始,首先,要给开发人员一个安全开发的副驾驶。

David Reber Jr指出,每个人都在安全中扮演一个角色,但不是每个人都是安全专家。因此,这个开始是最具战略性的意义,以指导开发人员撰写的程序代码,都遵循安全最佳实践。而Nvidia本身也正于工作流程中创建这样安全副驾驶,他们认为,安全助手是将生成式AI应用于网络安全的第一步。

第二,使用生成式人工智能来帮助分析漏洞,尤其是已知漏洞。毕竟每个程序代码的背后,可能根植于数十甚至数千种不同的软件分支和开源项目中。而Nvidia也测试了这个概念,像是读取公司所使用的软件,及其支持的功能与API政策,而帮助识别修补的结果,将加快人类分析师的速度,最多可提升4倍。

第三,用LLM填补不断增长的数据缺口。这里的情况是指,少有用户分享数据外泄资讯,所以很难预测攻击,此时可借助生成式AI创建合成数据,模拟未曾见过的攻击模式,或填补训练数据的空白,让机器学习系统在实际攻击发生之前,可以学会如何防御。

特别的是,Nvidia展示一项实证结果,是改进鱼叉式网络钓鱼(Spear Phishing)的侦测,在Morpheus应用框架与生成式AI的搭配之下,比起既有解决方案成效更好,可从70%提升至90%。

综合而言,企业除了看到生成式AI逐渐融入安全产品的趋势。对于企业自身而言,在内部的安全强化上,是否也想过运用生成式AI来解决一些安全风险问题,无论是打造或采用开发人员适用的安全助手,促进漏洞问题可以更早被解决,以及应对漏洞管理的挑战,借助生成式AI之力来帮助识别修补,都将是企业在2024年可以思考的议题,甚至从中衍生出更多样的应用萌生想法场景,让我们可以更好应对层出不穷的安全挑战。

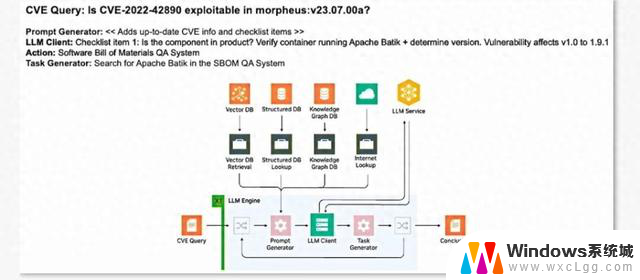

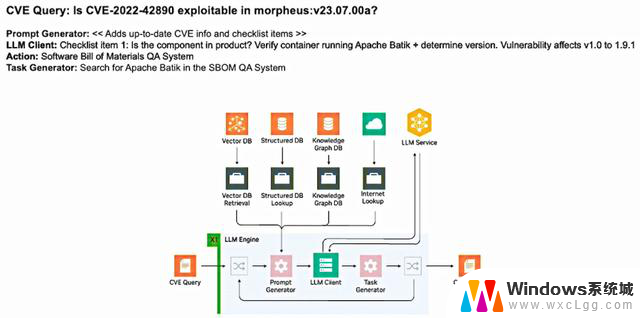

Nvidia用生成式AI找CVE漏洞

对于使用大型语言模型(LLM)引擎于安全,Nvidia展示找出容器中CVE漏洞可利用性的场景,并说明设计架构与运行流程。例如,当我们提问:“这个CVE在我的容器中是否可利用?”事实上,要解答这样的问题,背后需要知道的资讯很多,在LLM引擎运行之下,经由提示生成器、LLM Clinet到任务生成器,只问一次并不足以得到答案,总共是经过四次执行后,才得到结论。

Nvidia探讨用生成式AI强化安全的3种方式:加固网络防御、提升威胁检测和加强数据隐私保护相关教程

-

AMD 总裁探讨:生成式AI如何重塑科技未来?

AMD 总裁探讨:生成式AI如何重塑科技未来?2024-10-18

-

微软推出免费欧洲安全计划,助力政府网络安全加固

微软推出免费欧洲安全计划,助力政府网络安全加固2025-06-05

-

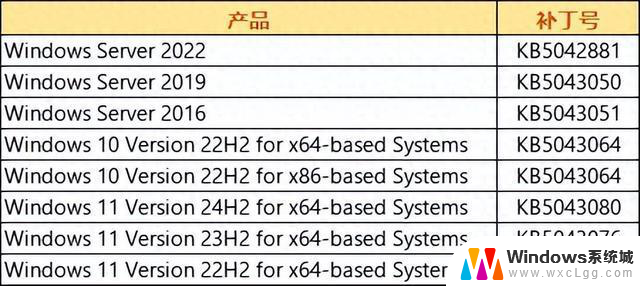

2024-09微软漏洞通告:如何保护你的数据安全?

2024-09微软漏洞通告:如何保护你的数据安全?2024-09-11

-

微软、OpenAI阻止俄罗斯、朝鲜的黑客使用AI大模型,保护网络安全的关键举措

微软、OpenAI阻止俄罗斯、朝鲜的黑客使用AI大模型,保护网络安全的关键举措2024-02-15

-

利用 NVIDIA SHARP 网络计算提升系统性能的最佳方法

利用 NVIDIA SHARP 网络计算提升系统性能的最佳方法2024-11-12

-

扫码登录安全性分析:显卡算力对密码防线构成威胁,账号安全需警惕

扫码登录安全性分析:显卡算力对密码防线构成威胁,账号安全需警惕2025-06-11

- Windows 11自带应用全面升级,提升用户体验和安全性

- AMD新款大缓存处理器曝光:R7 5700X3D和R5 5500X3D两款,性能强劲,全面提升用户体验

- 构建负责任且大规模的生成式人工智能的七个启示:如何打造安全可靠的AI系统?

- NVIDIA 实现通义千问 Qwen3 的生产级应用集成和部署指南

- 减配不减价?英伟达在华推出“二次阉割”显卡,用户反响几何?

- AMD市占,创历史新高:全球市场份额达到新高,AMD强势崛起

- 英伟达50 SUPER显卡或加量不加价:曝5080 SUPER售999美元,性价比超高!

- 为何网友认为WindowsXP与Windows7是最经典版本?- 为什么这两款操作系统备受推崇?

- 一家初创公司,要颠覆传统CPU,势必引领新一轮科技变革

- 微软Win11 24H2八月累积更新遇0x80240069错误解决方法

微软资讯推荐

- 1 减配不减价?英伟达在华推出“二次阉割”显卡,用户反响几何?

- 2 AMD市占,创历史新高:全球市场份额达到新高,AMD强势崛起

- 3 为何网友认为WindowsXP与Windows7是最经典版本?- 为什么这两款操作系统备受推崇?

- 4 AMD新款旗舰X3D计划曝光,双CCD 3D V-Cache产品是否存在?

- 5 历史首次!AMD服务器CPU市占率达50%:行业格局将如何变化?

- 6 初探微软Win11快速机器恢复功能:自动修复启动故障的操作步骤

- 7 英伟达回应:产品中绝对没有后门、终止开关或监控软件

- 8 基于国产CPU和OS的LLM应用开发平台资源计算方法专利

- 9 100元8代E3神教2144 2174 2274G处理器攻略:功耗50瓦U2固态32万分解析

- 10 Win10文件删除不了?教你两招轻松搞定,轻松解决Win10文件删除困难问题

win10系统推荐

系统教程推荐

- 1 笔记本开机闪屏是什么原因,怎么解决 笔记本电脑频繁闪屏怎么办

- 2 win10怎么更改子网掩码 Win10更改子网掩码步骤

- 3 声卡为啥没有声音 win10声卡驱动正常但无法播放声音怎么办

- 4 固态硬盘装进去电脑没有显示怎么办 电脑新增固态硬盘无法显示怎么办

- 5 word如何加批注 Word如何插入批注

- 6 怎么让word显示两页并排 Word文档同屏显示两页

- 7 win11直接改文件后缀 win11文件后缀修改教程

- 8 win11怎么查看电脑的物理地址 电脑物理地址查询方法

- 9 switch手柄对应键盘键位 手柄按键对应键盘键位图

- 10 win11安装共享打印机提示0000709 win11共享打印机提示0000709问题解决方法